Das Projekt

Ein virtueller und intelligenter Assistent

Ai.vatar steht für die Entwicklung eines intelligenten, menschenähnlichen Assistenten für den universellen und kostengünstigen Einsatz in einem virtuellen Umfeld (VR & AR). Ai.vatar ist das Produkt aus sprachgesteuertem Dialog-System und animierten, interaktiven digitalen Menschenmodellen.

In der virtuellen Welt kann Ai.vatar mit Menschen interagieren und z.B. als Tutor oder Coach in unterschiedlichsten Bereichen eingesetzt werden

Partner

Das Düsseldorfer Start-Up IOX ist ein Technologieunternehmen, das Prototypen neuer intelligenter Produkte entwickelt. Seit 2015 realisiert das Team „Internet of Things“ (IoT)-Prototypen für seine Kunden und gewann Ende 2017 den Gründerpreis des Landes NRW.

Dabei vereint IOX verschiedene Disziplinen wie fachliche bzw. methodische Beratung, Elektrotechnik, Industriedesign und Softwareentwicklung und kann seinen Kun-den so eine umfassende Lösung aus einer Hand bieten. IOX hat sich auf kundenspezifische Lösungen im Bereich IT und Industrie 4.0 spezialisiert.

Typische Produkte sind dabei virtuelle Assistenzsysteme wie Chatbots und künstliche Intelligenz zur Echtzeit-Bildanalyse. Neben technischen Dienstleistungen bietet IOX darüber hinaus Design Thinking und Rapid Design Workshops an, um mit seinen Kunden gemeinsam innovative Ideen für neue Produkte im Bereich IoT zu entwickeln. Hinter den Produkten verbergen sich verschiedene Technologien, Treiber sind dabei neue Megatrends aus den Bereichen Connectivity, Robotik und künstliche Intelligenz.

HHVISION wurde im Jahr 2000 mit den Schwerpunkten digitales Entwerfen und Konstruieren gegründet. Seit 20 Jahren entwickeln wir mit unseren 35 Mitarbeitern konstant den Qualitätsstandard der verschiedenen Darstellungsmedien architektonischer Planung weiter.

So stellen wir sowohl Gebäude und Städte, als auch digitale Menschmodelle so realitätsnah wie möglich in Form von Bildern, Animationen und als interaktive 3D-VR-Szenen dar.

In den letzten 10 Jahren forschte HHVISION in verschiedenen Themengebieten mit unterschiedlichen Kooperationspartnern. Dabei wurde die Projekte „Virtuell immersives Stadtplanungsmodells“, die „Virtuell immersiven Webkonferenz“ und „3D People in Motion“ durchgeführt, welche wegweisende neue virtuelle Darstellungsmethoden in den Bereichen Stadtplanung, virtuelle Konferenz digitale Menschmodelle aufzeigten. Aus den Projekten ergaben sich neue Arbeitsbereiche, die stetig ausgebaut werden und damit neue Fragen aufwerfen, die es zu erforschen gilt.

In dem Forschungsvorhaben Ai.vatar soll untersucht werden, wie sich digitale Menschmodell noch realistischer darstellen lassen, wie eine Kommunikation mit einem intelligenten digitalen Avatar umgesetzt werden kann und welche Schnittstellen geschaffen werden müssen, um einen qualitativen Dialog mit seinem digitalen Gegenüber halten zu können.

Die UNIVERSITÄT WITTEN/HERDECKE ist die erste private Universität Deutschlands und steht seit ihrer Gründung im Jahre 1982 für unkonventionelle, innovative und wegweisende Konzepte im Bildungssektor.

Am Lehrstuhl für Soziologie werden in theoretischen und empirischen Studien Fragen der digitalen Transformation der Gesellschaft zum Gegenstand gemacht. Forschungsschwerpunkte des Lehrstuhls sind unter anderem empirische Studien zu Virtual/Augmented Reality und theoretische Überlegungen zu Sozialität unter Bedingungen maschineller Intelligenz. Dies äußert sich in soziologischen und psychologischen Studien zu Plausibilität und Akzeptanz computergesteuerter Spielpartner im Bereich Gaming sowie in Nutzungsstudien im Bereich Virtual Reality mit HMDs wie Oculus Rift und HTC Vive. Auch experimentelle Studien zu Empathie und Embodiment in virtuellen Räumen zählen zu den quantitativen und qualitativen Forschungsschwerpunkten.

Für das Projekt Ai.vatar werden Fragen zur sozialen Akzeptanz von Avataren, adaptierten Körperbewegungen und emotionalem Ausdruck wissenschaftlich beantwortet. Diese Studien tragen dazu bei, dass der Ai.vatar sympathisch, intelligent und plausibel im virtuellen Raum auftreten kann.

Update

- Präsentation der Ergebnisse in der Zusammenarbeit mit Dr. Ausbüttel 23. September 2022

Am 22.9. präsentierten wir dem assoziierten Partnerunternehmen Dr. Ausbüttel das gemeinsam mit ihnen abgestimmte Demonstrations-Szenario „Beratung zur Wundversorgung“. Zu dem Treffen an der Universität Witten/Herdecke kamen Jannis Augustin und Sebastian Groß aus der Abteilung Professionelle Wundversorgung/Digitales Marketing des Unternehmens Dr. Ausbüttel. Beide zeigten sich sehr begeistert von der Demo und der entwickelten Technologie für den Einsatz von virtual humans in der Unternehmensrepräsentation.

Die Demo behandelt den fiktiven use-case einer Beratung zu Wundversorgungsartikeln des Unternehmens Dr. Ausbüttel. Hierzu werden nach einem kurzen Einführungsteil in die VR-Bedienung (Tutorial) Fragen zu einer bestehenden Wunde gestellt. Auf Grundlage der Antworten der Nutzenden wird dann eine Empfehlung zur Wundversorgung ausgegeben.

In der Demonstration werden alle bislang im Projekt erstellten Technologien integriert:

- Per Photogrammetrie erzeugte und animierte Darstellung der Ai.vatare

- Speech-to-Text und Text-to-Speech Integration

- Integration an den BotKitManager von IOX

- Dialogsteuerung per Google DialogFlow

- Multi-Avatar-Funktionalität: Zwei Ai.vatare übernehmen unterschiedliche Rollen in der Anwendung

- Virtual Reality und Desktop Anbindung

- Zwei Masterarbeiten erfolgreich beendet 21. April 2022

Mit Ablauf des Monats März wurden beide im Projekt Ai.vatar betreuten Masterarbeiten zu einem erfolgreichen Ende gebracht. Sowohl Sophia Bermond als auch Nele Kost haben ihre sehr gut bewerteten Arbeiten zur Erlangung des akademischen Grades Master of Science (M. Sc.) fertigstellen können.

In Sophias Arbeit mit dem Titel „Effekte der anthropomorphen Verkörperung eines sprachbasierten Agenten auf die soziale Wahrnehmung der Nutzenden in einer virtuellen Umgebung“ wurde in Form eines Mixed-Method Designs quantitativ untersucht, ob sich das Erleben sozialer Präsenz und die Zuschreibung von Sympathie, Vertrauenswürdigkeit und Natürlichkeit bei einem ECA mit einer 3D Verkörperung im Vergleich zu einem rein sprachbasierten Conversational Agent (CA) erhöht. Für die Untersuchung wurde der zu dem damaligen Zeitpunkt aktuellste Prototyp des Ai.vatar Systems eingesetzt, das eine verkörperte Darstellung eines Menschen mit sprachbasierten Interaktionsmöglichkeiten kombiniert. Entsprechend der Hypothesen wurde der ECA im Vergleich zu dem CA als vertrauenswürdiger eingeschätzt. Dagegen unterschied sich das soziale Präsenzerleben, die Einschätzungen der Sympathie und der Natürlichkeit nicht zwischen den Untersuchungsgruppen.

In Neles Arbeit mit dem Titel „Anthropomorphisierung im Kontext der Mensch-Maschine-Interaktion. Der Einfluss von technikbezogenen Persönlichkeitseigenschaften und Einstellungen auf die Vermenschlichung von Embodied Conversational Agents“ wurde der Einfluss von technikbezogenen Persönlichkeitseigenschaften und Einstellungen auf die Anthropomorphisierung eines künstlichen sozialen Agenten untersucht, um die individuelle Tendenz zur Anthropomorphisierung künstlicher sozialer Agenten besser zu verstehen. Das explanative Mixed-Methods-Design bestand aus einer Online-Befragung, die den Einfluss von Technikaffinität, Technophobie, Medienbasierter Empathie und Fantasy-Empathy auf die Anthropomorphisierung künstlicher sozialer Agenten erfassen sollte, die durch Interviews mit Teilnehmer*innen der Online-Befragung vertieft wurde. Die Auswertung zeigte einen positiven Effekt von Medienbasierter Empathie auf die Anthropomorphisierung in Bezug auf Mind Agency, von Anthropomorphisierung.

- Der Ai.Vatar als medizinscher Produktberater: Zusammenarbeit mit Dr. Ausbüttel 30. November 2021

Für unseren neuen Anwendungsfall haben wir uns Hilfe aus der Industrie geholt um zu beweisen, dass der Ai.vatar eine digitale Bereicherung für die Wirtschaft darstellen kann.

Dazu haben wir eine Zusammenarbeit mit Dr. Ausbüttel & Co GmbH gestartet um ein Szenario zu schaffen, in welchem der Ai.vatar als interaktiver medizinischer Produktberater agiert.

Im neuen Szenario wollen wir unsere Ai.vatar-Experience zudem um einen zweiten Ai.vatar erweitern, welcher dem User die Benutzung der VR-Brille beibringt und auch mit einem anderen Agenten kommunizieren kann.

Auch die Artificial Intelligence unserer Ai.vatare wird durch neue Techniken ausgebaut und um ein Vielfaches interaktiver und realistischer.

Die Planungs- und Koordinationsphase konnten wir zusammen in einem Workshop-Tag in Köln abschließen und freuen uns nun darauf die Pläne in die Realität umzusetzen.

- Teilnahme am Places-Festival und DIVR Science Award 20. September 2021

Wie schon angekündigt hat das Team Ai.vatar 2021 am Places Festival teilgenommen. Dort haben wir viele interessante Leute und Projekte kennengelernt und natürlich auch unser Projekt Ai.vatar vorgestellt. Es hat uns sehr gefreut, dass wir viel positives und auch wertvolles Feedback erhalten haben, welches wir direkt in den nächsten Prototypen einfließen lassen wollen. Für den DIVR Science Award hat es leider nicht gereicht, aber wir sind trotzdem stolz unter all den interessanten Projekten nominiert gewesen zu sein.

Nach der erfolgreichen Teilnahme am Festival freuen wir uns nun darauf, mit der Entwicklung des nächsten Prototyps zu starten.

- Der erste Ai.vatar: ein Demo-Video 27. Juli 2021Im Zuge der Bewerbung für das Places-Festival und dem damit verbundenen DIVR Science Award 2021 haben wir ein kurzes Demo-Video des Ai.vatars erstellt, welches die Grundfunktionen darstellen soll. Zu sehen ist ein kurzes Gespräch mit dem Ai.vatar. Die Userin trägt dabei eine VR-Brille und taucht vollständig in die virtuelle Umgebung ein. Um dies im Video gut darzustellen wechseln wir, sobald das Gespräch startet, in die reale Sichtweise der Userin und erkunden die Umgebung und den Ai.vatar mit ihr zusammen.

- Nominierung für den DIVR Science Award 2021 9. Juli 2021

Das Institut für Virtuelle Realitäten (DIVR) vergibt in Kooperation mit dem Places _ VR Festival jährlich den DIVR Science Award, der die besten Projekte der deutschen XR-Forschung in drei Kategorien auszeichnet.

Mit unserer Bewerbung stehen wir auf der Shortlist der Kategorie „best concept“, welche den innovativsten Ansatz, den kreativsten Einsatz oder das spannendste Experiment im Bereich Extended Realities bewertet. Für die Präsentation auf dem Festival und die Begutachtung der Jury entwickeln wir derzeit ein spezielles Szenario, das den aktuellen Stand des Ai.vatar Systems besonders gut zur Geltung bringen kann.

Das Festival und auch die Jurywertung finden statt vom 16. – 18. September 2021.

Mehr Infos unter: https://places-festival.de/divr-award-2021/

- Honourable Mention Award für Konferenzbeitrag 9. Mai 2021

Auf zwei internationalen Tagungen zu Conversational Agents konnten erste Ergebnisse aus dem Ai.vatar Projekt vorgestellt werden. Alexandra Hofmann und Jonathan Harth haben sowohl auf der „CUI@IUI Theoretical and Methodological Challenges in Intelligent Conversational User Interface Interactions“ (Honourable Mention Award) als auch der „CHI ’18: ACM CHI Virtual Conference on Human Factors in Computing Systems” erfolgreich Papers präsentiert. In beiden Beiträgen stellen Alexandra und Jonathan neue methodische Überlegungen vor, die Mixed Reality Darstellungen zur Analyse von Interaktionen mit virtuellen Agenten verwenden.

Paper Download: https://sputze.github.io/evaluating-mr/paper/#mixed-reality-methods-for-analysis-of-multimodal-human-agent-interactions

- Der Aivatar geht in die zweite Runde- und dieses Mal mit einem optimierten Workflow! 28. April 2021

Für diese kleine Demo haben wir den neu gescannten Aivatar Prototyp 2 an das Live Link Face angeschlossen. Dabei scannt ein Iphone das Gesicht des Nutzers und überträgt die Mimik in Realtime auf den digitalen Aivatar.

- Erste Nutzerstudie erfolgreich durchgeführt 15. März 2021

An der Universität Witten/Herdecke wurde im neu eingerichteten Mixed Reality Labor die erste Nutzerstudie mit dem Ai.vatar System durchgeführt. In dieser Studie stand die Frage im Vordergrund, wie sich die virtuelle Verkörperung des Ai.vatar auf die Wahrnehmung der Nutzer/innen und auch die Interaktion zwischen Nutzer/in und Agent auswirkt. Neben der Untersuchung, ob sich die User sich in sozialer Präsenz mit dem Agenten in der virtuellen Umgebung empfinden, untersuchten wir, inwiefern der Körper des Ai.vatar im Vergleich zu der

bloßen Stimme des Agenten zu einer stärkeren Wahrnehmung von Human-Likeness beitrug. Die Untersuchung wurde maßgeblich von Sophia Bermond durchgeführt.

- Der Dialog mit dem Ai.vatar 14. Februar 2021

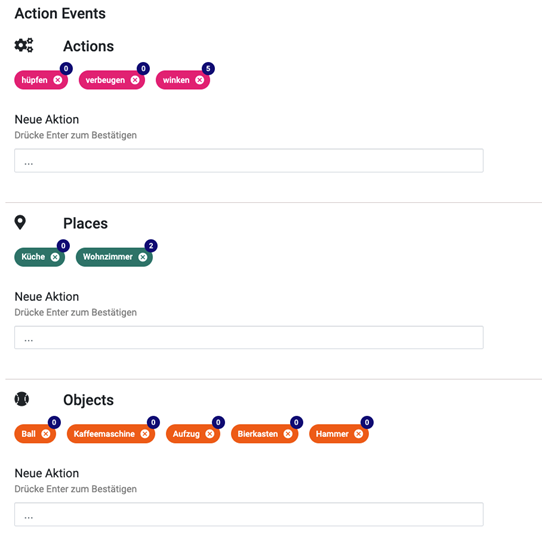

Inzwischen hat sich im Projekt „Ai.vatar“ viel getan! Der Avatar wurde an ein neu entwickeltes Bot-System angeknüpft, in welchem eigene Dialoge eingepflegt werden können. Der Ai.vatar reagiert dabei auf die vom Nutzer gesprochenen Spracheingabe und wählt entsprechend seine Antwort aus.

Mit Hilfe einer Gaming-Entwicklungsumgebung wird der vom Bot-System ausgewählte Dialog, mithilfe der Text-to-Speech-Methode von Google vertont. Dabei kann zwischen einer männlichen und einer weiblichen Stimme ausgewählt werden, passend zum jeweiligen Ai.vatar.

Gleichzeitig werden die Texte aus dem Dialog-System ausgewertet. Mittels digitaler Auswertemethoden wird dabei entschieden, welche Mund- und Mimik-Bewegung zum Dialog abgespielt werden sollen. Mit diesem Feature bewegt der Ai.vatar also seinen Mund passend zum Text und wird direkt ein ganzes Stück menschlicher.

Um dieses zu ermöglichen mussten 39 verschiedene Mimiken der Gesichtspartie aufgenommen und in den 3D-Bereich übertragen werden. Während des Gesprächs interpoliert der Ai.vatar dann, gemäß des Textes, zwischen den Extrem-Mimiken des Munds.

Das Projekt wird gefördert von:

©2020 HHVISION

©2020 HHVISION